0.背景

在现在世面有众多的大模型,如果能训练一个私有化的大模型帮助小型公司和个人搭建知识库,定会提高信息检索的效率,ollama框架就是如此。

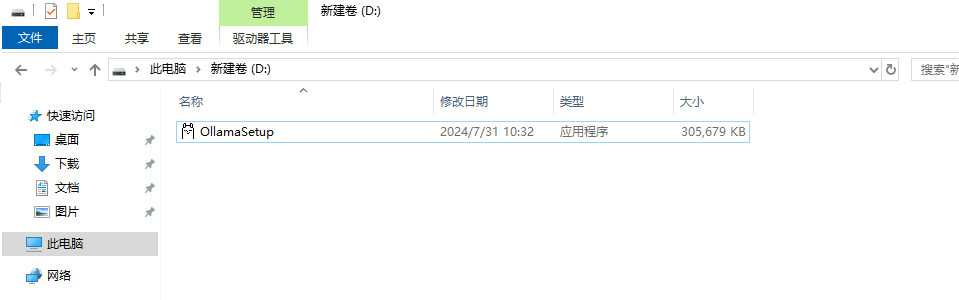

1. 安装ollama

Ollama是一个由Facebook AI Research开发的开源、轻量级且高效的大型语言模型(LLM)框架。它旨在使研究人员和开发人员能够更轻松地在自己的硬件上部署和运行LLM,而无需专门的云计算资源。

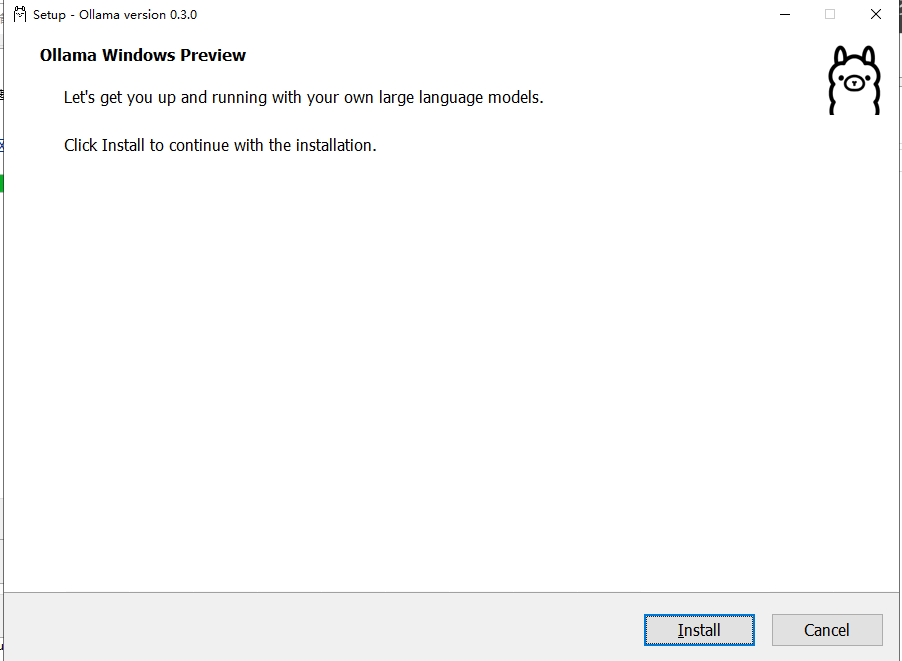

https://ollama.com/download下载完成并安装。

注意: windows 的安装默认不支持修改程序安装目录, 默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama 默认安装的模型目录:C:\Users\username\ .ollama 默认的配置文件目录:C:\Users\username\AppData\Local\Ollama

由于Ollama的模型默认会在C盘用户文件夹下的.ollama/models文件夹中,可以配置环境变量OLLAMA_MODELS,设置为指定的路径:

变量名为:OLLAMA_MODELS

变量值:D:\Ollama

监听变量:OLLAMA_HOST

监听值: 0.0.0.0:11434

其中D:\Ollama是你安装Ollama的位置。

设置好系统变量后需要重启电脑,这样新下载的模型就不会再放置在C盘,而是指定放置在环境变量所对应的位置。

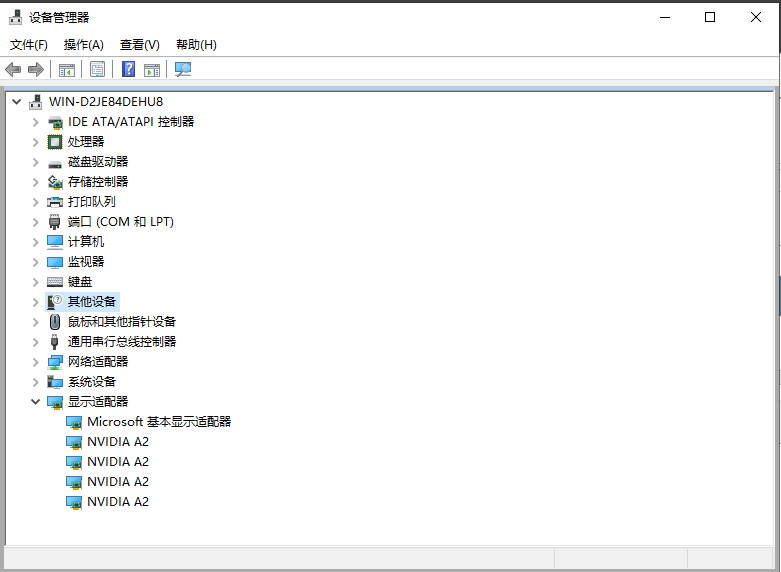

2. 准备具备显卡的主机

至少具备8G的显存,我这里采用4张NVIDIA A2的显卡,在设备管理器里发现已经处于正常驱动状态。

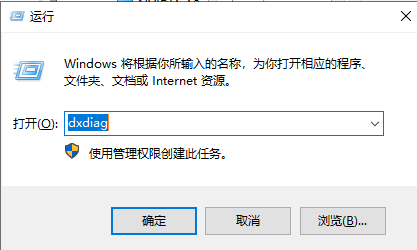

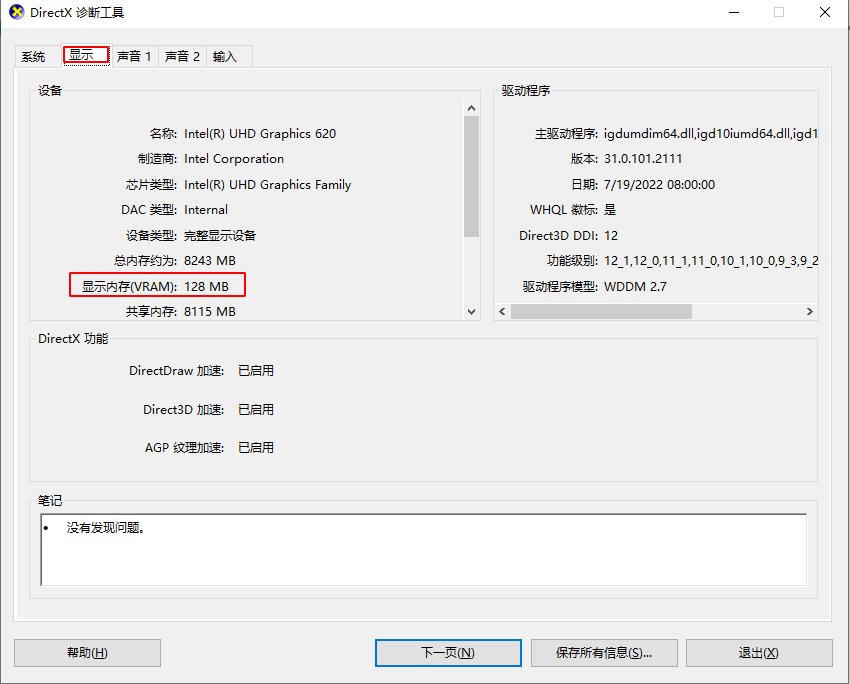

查看显存大小,在运行窗口中输入:dxdiag

切换到显示标签页,找到显示内存(VRAM)。

3. 安装llama3.1

https://ollama.com/library/llama3.1在命令行中,安装llama3.1模型

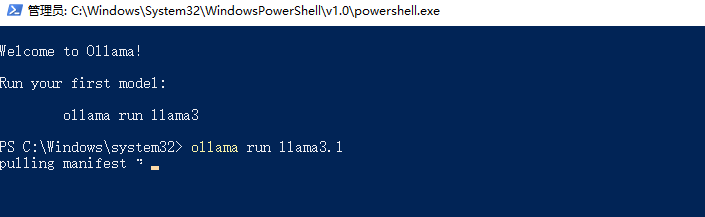

# 拉取模型

ollama pull llama3.1

# 运行模型

ollama run llama3.1

# 查看模型例表

ollama list

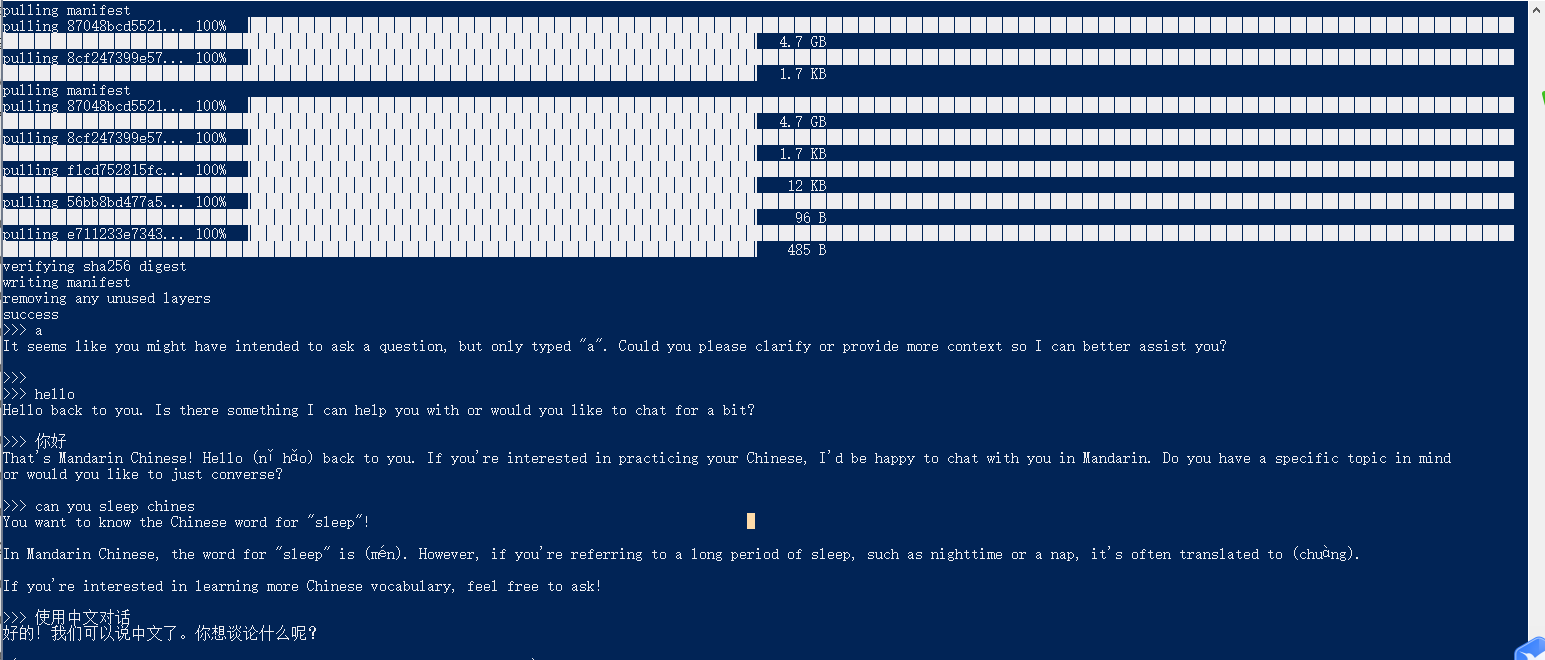

等待模型拉取。

等待安装完成。

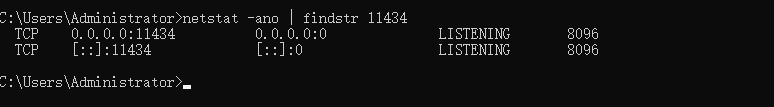

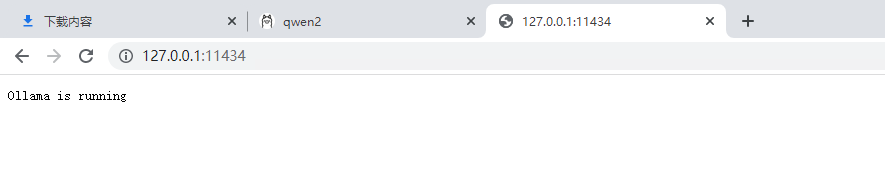

注:ollama会监听11434端口,因此可通过外部接口访问此api

4. 安装maxkb

MaxKB 是一款基于 LLM 大语言模型的知识库问答系统,由飞致云开发。通过MaxKB可以实现在网页上可视化使用大语言模型。本次采用docker-compose.yml 方式部署:

version: '3'

services:

maxkb:

image: cr2.fit2cloud.com/1panel/maxkb

container_name: maxkb

restart: always

ports:

- "9090:8080"

volumes:

- ~/.maxkb:/var/lib/postgresql/data

network_mode: "host"

admin密码:MaxKB@123..

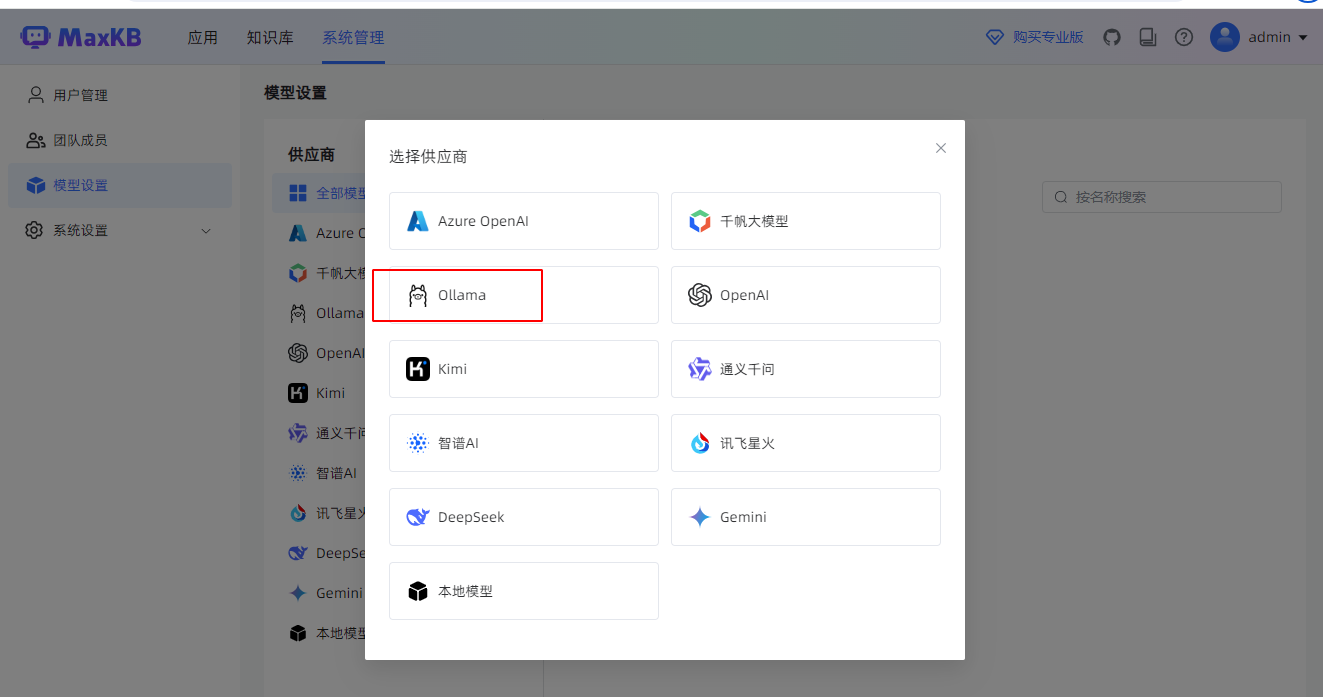

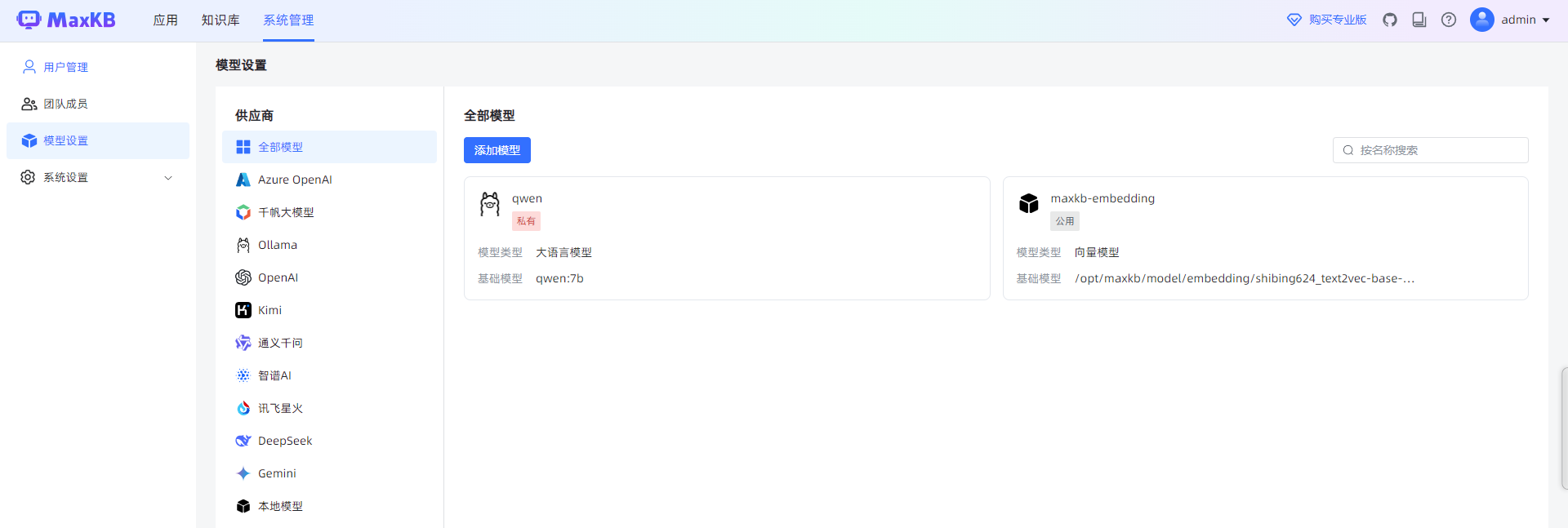

API处输入Ollama地址模型的地址,API Key处任意输入。

完成模型的建立。

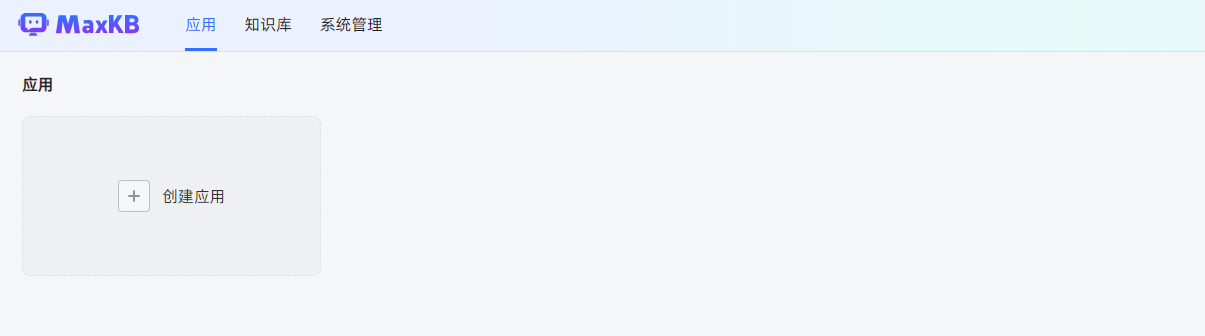

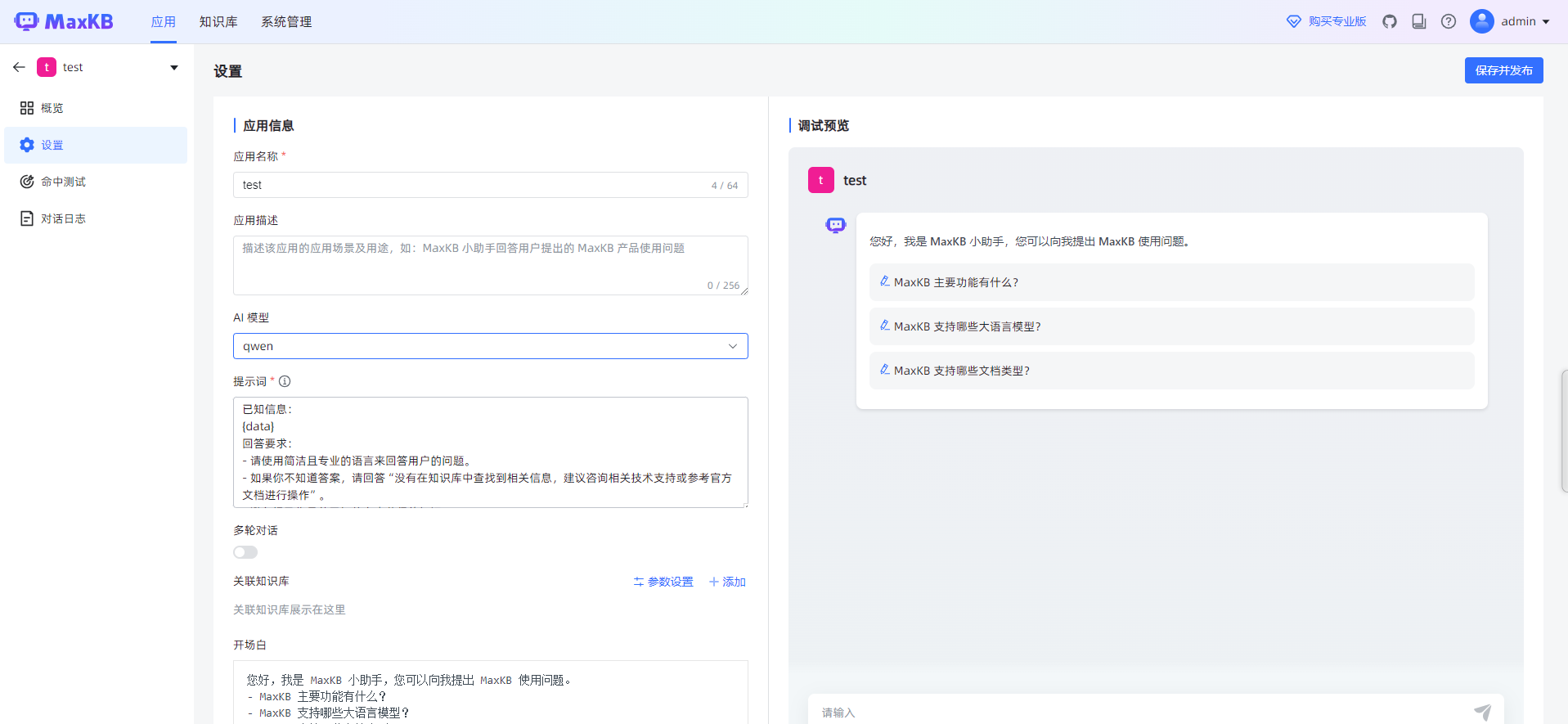

5. 创建应用

在应用处点击创建应用。

输入自定义的应用名称,我这里输入test。

选择关联好的ai模型,点击右上角的保存并发布。

回到概览,点击演示。

即可和大语言模型对话。也可以自定义知识库,训练私有模型,大家可以自行研究。

评论区